Open Access, Peer-reviewed

eISSN 2093-9752

Open Access, Peer-reviewed

eISSN 2093-9752

Ji Su Yoon

Sang Hong Park

Soo Ji Han

Sa Bin Chun

Beom Soo Kim

So Young Joo

Chang Hyeon Eom

Jong Chul Park

http://dx.doi.org/10.5103/KJAB.2024.34.4.232 Epub 2025 January 14

Abstract

Objective: The purpose of this study is to evaluate the clinical usability of markerless motion analysis by comparing single camera-based markerless motion analysis using computer vision and infrared camera-based motion analysis.

Method: This study was conducted on five healthy adults (age: 28.60 ± 5.24 years, height: 172.10 ± 7.06 cm, weight: 73.10 ± 14.07 kg). A single camera was installed in the sagittal plane, and the subject walked a total of 6 m along a path three times at his own pace. Position data of the joint centers of the shoulders, hips, knees, ankles, and toes and angle data of the lower extremity joints were calculated and analyzed.

Results: Joint center position data showed high agreement between methods for anterior-posterior and vertical movements, excluding medial-lateral movements. However, the reliability of markerless-based motion analysis showed lower reliability toward distal joints, and consistent errors were confirmed in medial and lateral movements. It was confirmed that the average error in the angle data of the lower extremity joints increased toward the distal joints.

Conclusion: Research results show that single camera-based markerless motion analysis using computer vision is effective for forward, backward, and vertical motion when photographed in the sagittal plane. However, large errors occur in depth data between the subject and the camera, which can affect other biomechanical variables. Therefore, it is effective in terms of real-time analysis, easy setup, and low cost when using a single camera, but it is emphasized that supplementation with depth data is necessary for accurate analysis.

Keywords

Markerless motion capture Single RGB camera Computer vision Pose estimation BlazePose Gait analysis

보행은 인간의 기본적인 움직임으로, 근골격계 및 신경계 질환부터 심혈관 질환 및 보행 장애 등 다양한 건강 문제의 진단과 재활 효과 평가에 중요한 단서를 제공한다(Pirker & Katzenschlager, 2017; Hulleck, Menoth Mohan, Abdallah, El Rich & Khalaf, 2022). 또한 보행의 패턴과 움직임을 정확하게 평가하여, 파킨슨병, 뇌졸중, 관절염 등 다양한 질환의 조기 발견과 치료 및 재활 전략을 수립하는 데 중요한 역할을 한다(Hollman, McDade & Petersen, 2011). 이러한 단서를 체계적으로 확인하고 정량화하기 위해서는 보행 분석은 필수적이다(Winter, 1991). 현재 보행 분석을 위한 동작 분석 방법으로 적외선 카메라를 활용한 3차원 모션 캡처 시스템과 IMU (Inertial Measurement Unit)와 같은 웨어러블 센서를 활용한 모션 캡처 등 다양한 기법이 존재한다. 인간의 동작 분석에는 주로 적외선 카메라 기반 3차원 모션 캡처 시스템이 사용되며, 비교적 오랫동안 높은 정확도와 신뢰성을 제공해왔다(Colyer, Evans, Cosker & Salo, 2018; Maynard, Bakheit, Oldham & Freeman, 2003). 그러나 이러한 전통적인 방법은 고가의 장비, 넓은 설치 공간, 전문가의 필요성, 그리고 피험자에게 마커를 부착해야 하는 불편함 등 시공간적 측면에서 여러 한계점을 가지고 있다(McGinley, Baker, Wolfe & Morris, 2009; Carse, Meadows, Bowers & Rowe, 2013). 앞선 단점은 임상 환경이나 일상적인 상황에서 보행 분석을 어렵게 만들 뿐만 아니라, 피험자에게 심리적 부담을 주어 자연스러운 동작을 방해할 수 있다.

최근 컴퓨터 비전 기술의 발전은 이러한 문제를 해결할 수 있는 새로운 대안으로 떠오르고 있다(Kidziński et al., 2020; Stenum et al., 2021). RGB 카메라를 활용한 동작 분석 기술은 비용과 설치의 복잡성을 줄이는 동시에, 다양한 환경에서 활용 가능하다는 장점을 지닌다. 여러 대의 RGB 카메라를 동기화하여 사용하는 다중 카메라 기반 시스템은 기존 적외선 기반 시스템과 유사한 수준의 정확도를 보여준다(Uhlrich et al., 2023). Ripic 등 (2023)에 의해 수행된 연구에서는 보행 동작에 대해 마커와 마커리스 데이터를 다중 카메라를 통해 동시에 수집하였고, 관절 중심점의 위치와 관절 각도의 정량적인 비교를 통해 시상면에서 유사한 일치도를 확인할 수 있었다. 또한 현재 상용화되어 있는 다중 카메라 기반 마커리스 시스템인 Theia3D (Theia Markerless Inc., Kingston, ON, Canada)는 달리기와 같은 비교적 빠른 동작에 대해 마커 기반 분석과 시상면, 관상면, 횡단면 순으로 큰 차이가 없어, 정확한 분석 및 임상 적용의 잠재력을 가진다(Moran, Rogler & Wager, 2023). 이와 같이 다중 카메라를 활용한 연구에서는 신체의 3차원 위치와 관절 각도를 정밀하게 측정하여 스포츠 경기, 재활 훈련, 무용 동작 분석 등 다양한 분야에서의 활용 가능성을 입증하였다.

그러나 다중 카메라 기반 시스템은 여전히 설치와 동기화 과정이 복잡하고 비용적인 부담이 크다는 한계를 가지고 있다(Wang et al., 2024). 한계를 극복하기 위해 제시된 단일 RGB 카메라를 활용한 동작 분석은 보다 간단하고 실용적인 접근법으로 주목받고 있다. 단일 카메라는 다중 카메라에 비해 비용이 저렴하며, 모바일 기기에서도 구현이 가능하고, 설치가 간단하여 소규모 공간에서도 동작 분석이 가능하다. 이러한 특성은 병원이나 재활 센터와 같은 임상 환경에서도 활용될 가능성을 보여준다(Yoo, Choi & Kim, 2012). 그러나 단일 카메라 기반 기술은 정확도와 신뢰성 면에서 기존 시스템에 비해 제한이 있을 수 있으며, 이를 개선하기 위한 기술적인 발전과 검증이 요구된다.

이와 같은 배경에서 Google의 BlazePose는 단일 RGB 카메라를 활용한 신체 관절 추적 기술로 주목받고 있다. Blaze- Pose는 단일 카메라로도 딥러닝 기반 모델을 사용하여 신체의 주요 관절(Key points)의 위치를 실시간으로 추적할 수 있으며, 2D 및 3D 동작 분석을 가능하게 한다(Ohri, Agrawal & Chaudhary, 2021). 본 모델은 모바일 환경에 최적화되어 있어 비교적 가벼운 모델로, 생체 역학에서 일반적으로 쓰이는 모델인 OpenPose보다 빠르게 추정 가능하다는 특징이 있다. 모델은 알고리즘 내에서 얼굴 감지기 모델인 BlazeFace를 통해 사람을 인식하고, 골반을 중심으로 총 33개의 키포인트를 형성한다. 현재 모델은 딥러닝 및 머신러닝과 결합하여 단일 카메라 기반 낙상 감지, 보행 식별 등 가벼운 동작 식별 모델을 만드는데 활용되고 있다(Zhang et al., 2023; Young et al., 2023; Arrowsmith, Burns, Mak, Hardisty & Whyne, 2022). 이에 따라 BlazePose를 활용한 단일 카메라 기반 동작 분석의 유효성을 검증하기 위한 비교 연구가 필요하다.

본 연구는 BlazePose 기반 단일 카메라 시스템과 기존 적외선 카메라 기반 마커 시스템을 비교 분석함으로써 두 시스템 간 동작 분석 결과의 유사성을 확인하고 단일 카메라 시스템의 정확성과 신뢰성을 분석하는 것을 목적으로 한다. 또한 단일 카메라 기반 시스템의 한계를 분석하고, 이를 기반으로 임상 환경에서 활용될 가능성을 검토하며, 향후 연구 방향으로 단일 카메라 시스템의 정확도를 높이기 위한 개선 방안을 제시하고자 한다. 이를 통해 단일 카메라 기반 컴퓨터 비전 기술이 적외선 기반 시스템을 대체하거나 보완할 수 있는 가능성을 탐구하고자 한다.

1. 연구 대상

본 연구는 최근 6개월간 부상 및 근골격계 이상이 없는 성인 남성 3명, 여성 2명을 대상으로 진행하였다. 모든 연구 대상자는 연구 목적, 실험 절차 및 주의 사항을 듣고, 실험 참여에 동의한 대상자만 데이터 수집을 진행하였다. 본 연구는 본교 생명윤리 위원회로부터 승인을 받았으며(IRB 승인번호: PKNU_20241211_2024082602961), 모든 참가자로부터 자발적으로 참여한다는 서면 동의서를 받았다. 연구 대상자의 우세측 다리는 모두 우측이며, 자세한 특성은 <Table 1>과 같다.

|

Variables (m ± sd) |

Male (n=3) |

Female (n=2) |

|

Age (years) |

26.33±0.47 |

32.00±7.00 |

|

Height (cm) |

176.33±5.91 |

165.75±2.25 |

|

Weight (kg) |

82.00±11.43 |

59.75±1.25 |

2. 측정 도구

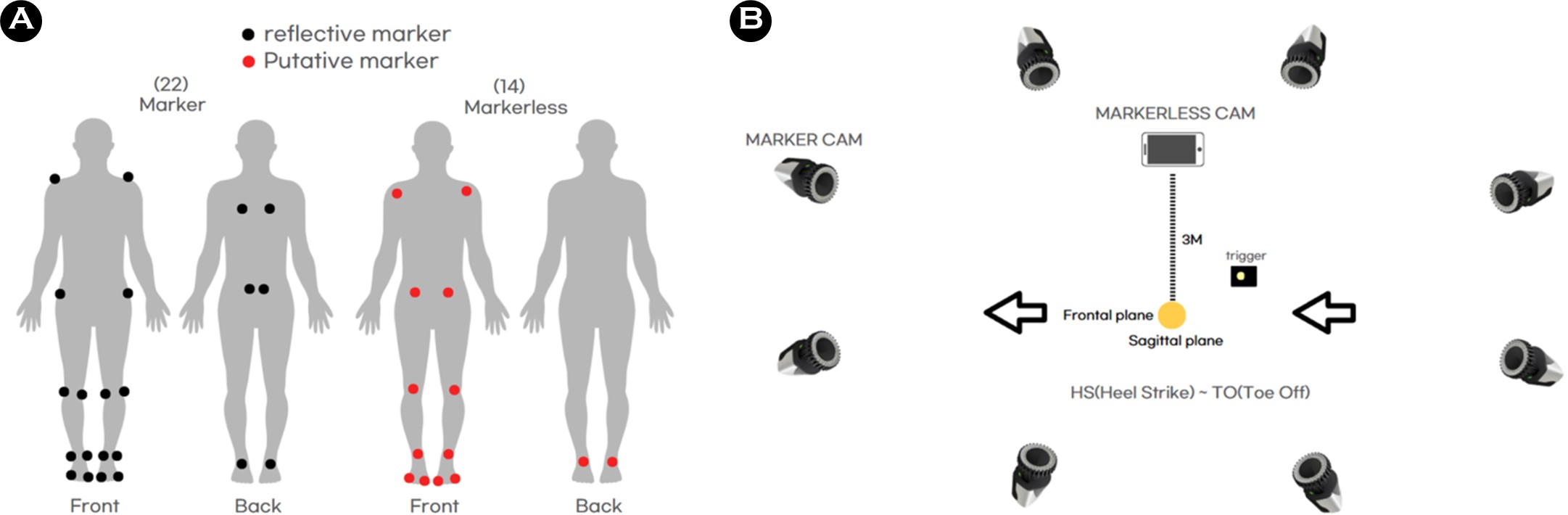

마커의 위치 데이터를 수집하기 위해 8대의 광학 모션 캡처 카메라(Miqus M5; Qualisys AB, Gothenburg, Sweden; sampling rate 120 Hz)와 QTM software (Qualisys Track Man- ager; QTM, Qualisys AB, Sweden)를 사용하였다. 또한 실험 전, 보행 동작이 이루어지는 공간의 3차원 좌표화를 위해 L자 완드를 사용하여 NLT (Non-Linear Transformation) 방식의 동조(calibration)를 진행하였다. 이때 3차원 공간 좌표의 경우 좌우 방향을 x 축, 전후 방향을 y 축, 수직 방향을 z 축으로 정의하였다. 다음으로 연구 대상자들의 신체 몸통 및 하지 관절을 포함한 총 8개의 분절 구성을 위해 22개의 12 mm 반사마커(reflective marker)를 양측 하지의 해부학적 위치(견봉쇄골, 견갑골, 상후장골극, 대퇴골 외측상과, 대퇴골 내측상과, 외측 복사뼈, 내측 복사뼈, 종골, 첫 번째 중족골, 다섯 번째 중족골)에 부착하였다(Figure 1A 참조) (Ripic et al., 2023).

마커리스를 통한 관절 중심 위치 데이터는 1차적으로 영상 수집을 위해 1대의 핸드폰 카메라(iPhone 11, 4K HD; sampling rate 60 Hz)를 사용하였다. 실험실 구성은 <Figure 1b>와 같이 대상자로부터 3 m의 거리의 시상면에 핸드폰을 설치하였고, 카메라 렌즈가 지면으로부터 1.5 m의 높이에 위치하도록 설정하였다(Yang & Park, 2024). 이후 모든 영상은 트리거를 활용하여 마커의 위치 데이터 수집과 마커리스 영상 데이터 수집의 시작 시점을 일치시켜 주었다(Auer, Süß & Dendorfer, 2024).

3. 연구 절차

모든 대상자는 본인의 신체 분절 크기에 맞는 준비된 타이즈로 환복한 후, 실험 수행을 위해 10분간 동작 연습을 수행하였다. 동작은 대상자가 편하고 선호하는 보행 속도로 총 6 m의 주로를 3번씩 보행하였고, 카메라와 직교하는 지점에서 우세측 다리인 오른발이 카메라에 보일 수 있도록 요청하였다. 모든 동작 수행은 자연스러운 움직임을 위해 최소 피드백을 제공하였으며, QTM software에서 마커 손실이 없고, <Figure 2>과 같이 마커리스 영상 내에 대상자의 얼굴부터 발끝까지 모두 나온 것을 1회 성공으로 간주하여 총 3회 데이터를 획득하였다.

4. 자료 처리

모든 데이터 처리는 Python v3.9.19를 사용하였으며, 마커리스 모션 캡처 시스템의 구동은 NVIDIA GeForce RTX 4060 Laptop GPU, AMD Ryzen 7의 프로세서로 구현되며, Jupyter Notebook에서 처리되었다. 마커 데이터는 QTM software를 통해 위치 데이터를 획득하였고, 마커리스와 똑같이 비교하기 위해 각 하지 관절마다 3면 움직임의 중심점을 추출하였다.

마커리스 데이터는 BlazePose 모델을 통해 총 33개의 관절 중심점을 추출하였고, 그 중 하지 관절 추출을 위해 어깨, 엉덩, 무릎, 발목, 발가락 관절을 포함한 총 14개의 관절 중심점을 추출하였다. 이때 BlazePose 모델의 3차원 공간 좌표 움직임은 어느 면에서 촬영하는지에 따라 달라지기 때문에, QTM software에서 사용하는 방향 축으로 동일하게 설정해 주었다. 마커 데이터와 마커리스 데이터 각각의 전처리가 끝난 후, 두 데이터 모두 데이터의 잡음(noise)을 최소화하기 위해 4차 저역 통과 필터링(4th-order lowpass Butterworth filtering, cut-off frequency: 6 Hz)을 수행하였다.

5. 분석 변인

분석 구간은 Heel Strike부터 Toe Off까지로 정의하였고, 그 구간을 100%로 시간 정규화해 주었다. Heel Strike는 발뒤꿈치의 z 축 위치가 가장 낮을 때로 정의하고, Toe Off는 발가락의 z 축 위치가 가장 낮을 때로 정의하였다(Van Hooren, Pecasse, Meijer & Essers, 2023).

산출 변인은 어깨, 엉덩, 무릎, 발목, 발가락 관절 중심점의 위치 데이터와 하지 관절 각도 데이터로, 위치 데이터의 경우 미터 단위를 갖고 있는 마커 데이터와 픽셀 단위를 갖고 있는 마커리스 데이터를 비교하기 위해 Min-Max 정규화를 진행하였다. 각 세그먼트는 Hulleck et al. (2024)에서 정의한 대로 몸통은 어깨-엉덩 관절로, 허벅지는 엉덩-무릎 관절, 정강이는 무릎-발목 관절, 발은 발목-발가락 관절로 정의되었다. 엉덩 관절 각도 데이터의 경우 아래 방정식에 설명된 대로 몸통(세그먼트 1) 및 허벅지(세그먼트 2) 벡터를 통해 산출되었다. 나머지 무릎 관절 각도 또한 허벅지 및 정강이 세그먼트 벡터를 기반으로, 발목 관절 각도는 정강이 및 발 세그먼트 벡터를 기반으로 정의되었다.

통계 분석은 1차원 통계적 매개 변환을 위한 패키지인 SPM1D의 코드를 활용하여, 시간에 따라 변화하는 시계열 데이터를 분석하였다. 각 방법의 대상자 간 보행이 일관성을 가지는지 신뢰성 검증을 위해, 급내 상관계수인 ICC (Intraclass Correlation Coefficient)를 구하였고, 두 방법 간에 어느 정도의 일치도를 가지는지 방법 간 ICC를 구하였다. ICC 계수는 매우 높은 신뢰도 및 일치도(1.00~0.81), 높은 신뢰도 및 일치도(0.80~0.61), 보통 신뢰도 및 일치도(0.60~0.41), 낮은 신뢰도 및 일치도(0.40~0.21), 매우 낮은 신뢰도 및 일치도(0.20~ 0.00), 그리고 음수 값일 경우 신뢰도 및 일치도가 전혀 없음을 나타낸다. ICC 상관계수 산출 공식은 다음과 같다.

또한 하지 관절 각도에 대해 Shapiro-Wilk 검정을 통해 정규성 검정을 진행하였고, 표본 수 및 데이터 수가 작아, 모든 하지 관절 데이터가 정규성을 만족하지 못하여, Spearman 상관계수(Spearman's rank correlation coefficient)를 통해 통계 분석을 실시하였다. Spearman 상관계수는 -1에서 1 사이의 값을 가지며, 매우 강한 상관관계(±1.00~±0.81), 강한 상관관계(±0.80~±0.61), 보통 상관관계(±0.60~±0.41), 약한 상관관계(±0.40~±0.21), 매우 약한 상관관계(±0.20~0.00)로 나뉜다. +는 양의 상관관계, -는 음의 상관관계로 해석된다. Spearman 상관계수 산출 공식은 다음과 같다.

위 식에서 는 마커와 마커리스 두 데이터 쌍에서 두 변수의 순위 차이를 뜻하고, n은 데이터 쌍의 총 개수, 6은 상수로 Spearman 상관계수 공식을 정규화하기 위해 곱하는 값을 말한다. 모든 변인에 대한 통계적 유의수준은 α=.05로 설정하였다.

1. 위치 데이터

<Table 2>에서는 하지 관절 각도 추출에 필요한 관절의 위치 데이터인 어깨, 엉덩, 무릎, 발목, 발가락 관절을 대상으로, 마커와 마커리스 위치 데이터의 대상자 간 신뢰도와 방법 간 일치도, 상관계수를 나타낸다.

|

Between subject |

Medial/Lateral |

|

Anterior/Posterior |

|

Vertical |

||||

|

ICC (p) |

|

||||||||

|

M |

Shoulder |

0.984

(.001*) |

|

0.857

(.010*) |

|

0.984

(.001*) |

|||

|

Hip |

0.627 (.109) |

|

0.871

(.007*) |

|

0.997

(.001*) |

||||

|

Knee |

0.957

(.001*) |

|

0.863

(.008*) |

|

0.997

(.001*) |

||||

|

Ankle |

0.926

(.001*) |

|

0.849

(.011*) |

|

0.871

(.007*) |

||||

|

Toe |

0.857

(.010*) |

|

0.846

(.012*) |

|

0.939

(.001*) |

||||

|

ML |

Shoulder |

0.952

(.001*) |

|

0.999

(.001*) |

|

0.988

(.001*) |

|||

|

Hip |

0.952

(.001*) |

|

0.994

(.001*) |

|

0.922

(.001*) |

||||

|

Knee |

0.953

(.001*) |

|

0.965

(.001*) |

|

0.804

(.024*) |

||||

|

Ankle |

0.960

(.001*) |

|

0.610 (.119) |

|

0.620 (.113) |

||||

|

Toe |

0.946

(.001*) |

|

0.498 (.188) |

|

0.506 (.183) |

||||

|

Inter method |

ICC (p) |

r

(p) |

|

ICC (p) |

r

(p) |

|

ICC (p) |

r

(p) |

|

|

M vs ML |

Shoulder |

-0.137 (.684) |

-0.06 (.677) |

|

0.999 (.001*) |

1.00 (.001*) |

|

0.926 (.001*) |

0.83 (.001*) |

|

Hip |

0.944

(.001*) |

0.81

(.001*) |

|

0.999 (.001*) |

1.00 (.001*) |

|

0.981 (.001*) |

0.96 (.001*) |

|

|

Knee |

0.124 (.310) |

0.06 (.634) |

|

0.999 (.001*) |

1.00 (.001*) |

|

0.892 (.001*) |

0.69 (.001*) |

|

|

Ankle |

-0.707 (.976) |

-0.21 (.113) |

|

0.999 (.001*) |

0.99 (.001*) |

|

0.994 (.001*) |

0.95 (.001*) |

|

|

Toe |

-0.076 (.608) |

0.07 (.599) |

|

0.997 (.001*) |

0.91 (.001*) |

|

0.884 (.001*) |

0.73 (.001*) |

|

|

Note. *Significant

difference at p<.05, M: Marker,

ML: Markerless, r: Spearman's rank correlation coefficient |

|||||||||

마커 기반 관절 중심 위치 데이터의 대상자 간 신뢰도는 엉덩 관절의 내/외측 움직임을 제외한 모든 관절 및 움직임이 0.8 이상의 높은 신뢰도가 나타났다(p<.05). 반면 마커리스 기반 대상자 간 신뢰도는 어깨, 엉덩, 무릎 관절과 같은 비교적 근위 관절은 높은 신뢰도를 나타냈으나(p<.05), 발목, 발가락과 같은 원위 관절은 전/후 움직임에서 각각 0.610, 0.498을, 수직 움직임에서 0.620, 0.506으로 낮은 신뢰도를 보였다.

마커와 마커리스 기반 관절 중심 위치 데이터의 방법 간 일치도는 내/외측 움직임에서 어깨, 엉덩, 무릎, 발목, 발가락 관절 각각 -0.137, 0.944, 0.124, -0707, -0.076으로, 엉덩 관절을 제외한 모든 관절에서 매우 낮은 일치도가 나타났다. 전/후 및 수직 움직임에서는 모든 관절이 높은 일치도 및 상관관계가 나타났다(p<.05).

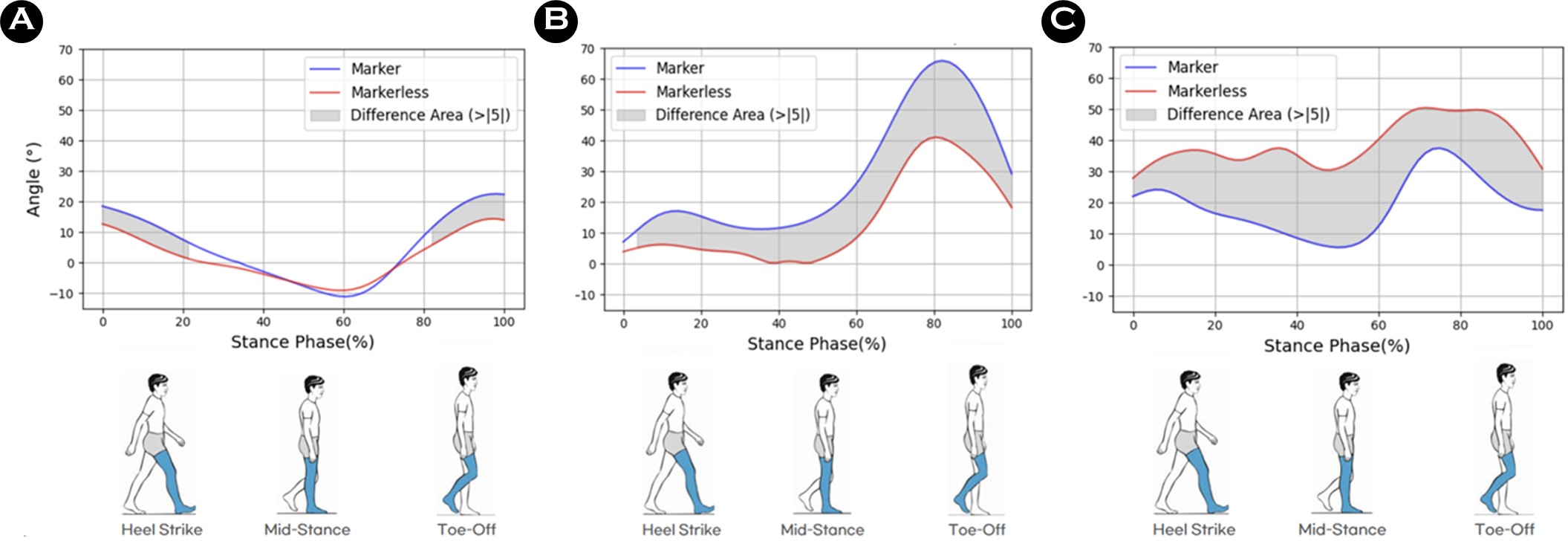

2. 각도 데이터

마커와 마커리스 기반 관절 중심 위치 데이터를 통해 산출한 하지 관절의 각도 데이터의 일치도와 상관관계, 평균 차이는 <Table 3>과 같다.

|

Variables |

ICC (p) |

r (p) |

Mean error ± Standard deviation (°) |

|

Hip Flexion/Extension |

0.928 (.001*) |

0.97 (.001*) |

3.93±4.80 |

|

Knee Flexion/Extension |

0.926 (.001*) |

0.89 (.001*) |

14.90±10.21 |

|

Ankle Dorsi/Plantar Flexion |

0.728 (.001*) |

0.65 (.001*) |

20.08±12.49 |

|

Note. *Significant

difference at p<.05 |

|||

각 프레임 별 일치도를 비교하였을 때, 모든 관절에 대해 매우 높은 일치도를 나타냈지만, 원위 관절로 갈수록 일치도가 낮아지는 것을 알 수 있다. 상관관계 또한 모두 유의미한 상관이 나타났지만, 원위 관절로 갈수록 상관관계가 낮아졌다. 평균 차이 또한 엉덩 관절 3.93°, 무릎 관절 14.90°, 발목 관절 20.08°로, 원위 관절로 갈수록 높은 차이를 나타낸다는 것을 알 수 있다(Figure 3 참조).

본 연구는 BlazePose 기반의 단일 카메라 시스템과 적외선 카메라 기반 마커 시스템 간 관절 위치 및 각도 데이터를 비교하여 두 시스템의 신뢰성과 유사성을 확인하고자 하였다. 마커 기반 시스템은 모든 관절에서 높은 신뢰도를 나타냈으며, 이는 대상자 간 관절 위치 데이터가 일관되게 측정되었음을 보여준다. 반면, 마커리스 데이터는 어깨, 엉덩, 무릎과 같은 근위 관절에서 높은 신뢰도를 나타냈지만, 발목, 발가락과 같은 원위 관절에서 전후 및 수직 움직임의 비교적 낮은 신뢰도를 나타냈다. 하지만 위치 데이터의 방법 간 일치도 결과를 살펴보면, 내외측 움직임에서 엉덩 관절만이 강한 일치도를 보이고, 다른 관절은 낮은 일치도를 보인다. 이는 BlazePose가 엉덩 관절을 기준으로 좌표를 구성하기 때문에 엉덩 관절만 높은 일치도를 보이고, 나머지 관절에서는 내외측 움직임의 일관된 오류가 발생했기 때문으로 사료된다(Ohri et al., 2021). 전후 움직임에서는 모든 관절이 높은 일치도를 나타냈다. 다중 카메라를 활용한 Ripic 등 (2023)이 수행한 연구에서도 관절 중심 위치 데이터의 전후 움직임은 1.00의 높은 일치도를 나타냈다. 이는 카메라의 개수에 상관없이, 추정 시 움직이는 관절의 방향은 잘 추정한다는 것을 알 수 있다. 더불어, 대부분의 보행 동작이 시상면에서 이루어지고, 본 연구에서 카메라가 시상면에 배치되어 있어 나타난 결과로 보인다.

관절 각도 데이터를 비교한 결과, 원위 관절로 갈수록 일치도가 감소하는 경향이 확인되었다. 이는 원위 관절에서 위치 데이터의 오차가 누적되어 각도 추정 정확도에 영향을 미친 결과로 해석된다. 엉덩 관절의 각도 데이터는 ICC 계수가 0.928로 높은 일치도를 보였으며, 상관관계 또한 0.97로 높은 상관성을 유지하였다. 무릎 관절의 각도 데이터 또한 ICC 계수 0.926, 상관계수 0.89로 높은 수준의 일치도 및 상관성을 보였으나, 둘의 패턴만 비슷할 뿐 평균 오차는 14.90°로 다소 일치도가 낮았다. 발목 관절의 각도 데이터는 ICC 계수 0.728, 상관계수 0.65로 하지 관절 중 가장 낮은 수준의 일치도를 나타냈으며, 평균 각도 차이가 20.08°로 가장 크게 나타났다. 이는 BlazePose의 단일 카메라 기반 깊이 추정 과정에 한계가 있음을 알 수 있다. Young, Mason, Morris, Stuart & Godfrey (2023)에 의해 수행된 연구에서는 BlazePose 기반 단일 카메라를 통해 트레드밀 위에서 달리기 중 무릎, 발목 각도와 시공간 매개변수를 비교하였다. 이때 무릎과 발목 관절은 각각 0.97, 0.84의 상관 계수를 나타내, 본 연구와 동일하게 원위 관절로 갈수록 일치도가 감소함을 볼 수 있었다. 또한 카메라 여러 대를 활용한 보행 분석 시에도 무릎과 발목 관절의 굴곡 각도가 과소평가 되었다는 결과가 나타났다(Moro, Marchesi, Hesse, Odone & Casadio, 2022).

본 연구는 몇 가지 한계점을 지니고 있다. 첫째, 피험자 수가 적어 데이터의 정규성이 확보되지 않았으며, 다양한 피험자를 대상으로 한 연구를 통해 일반화 가능성을 높일 필요가 있다. 둘째, 분석 구간을 카메라와 직교하는 오른발의 Heel Strike부터 Toe Off까지로 한정하였기에, 모든 보행 구간에 대한 일반화에는 한계가 존재한다. 이는 향후 동작 분석의 제약이 될 수 있으므로, 영상 내 모든 움직임을 정량적으로 분석하는 후속 연구가 필수적이다. 또한 본 연구는 대상자와 카메라 사이의 거리, 즉 깊이 데이터를 추정하는 과정에서 제한점을 확인하였다. 이러한 문제를 개선하기 위해 카메라 위치의 최적화와 새로운 깊이 추정 알고리즘의 개발이 필요할 것으로 보인다. 아울러 원위 관절의 낮은 일치도를 해결하기 위해 다양한 보행 조건과 더 많은 데이터를 포함한 후속 연구가 요구된다. 이번 연구 결과는 BlazePose와 마커 기반 시스템이 근위 관절의 위치 및 각도 데이터를 정확하게 분석할 수 있는 가능성을 보여준다. 특히 시상면 상의 움직임 분석에서 높은 정확성을 보였으며, 이는 임상적으로 단일 카메라 기반 시스템이 제한된 환경에서 보조적 도구로 활용될 가능성을 제시한다.

본 연구는 단일 카메라 기반 BlazePose와 적외선 카메라 기반 마커 시스템의 일치도와 상관성을 분석하여 단일 카메라 시스템의 가능성과 한계를 평가하였다. 모델은 생체역학적 측면에서 근위 관절, 특히 엉덩 관절과 무릎 관절에서 높은 신뢰도와 일치도를 보여, 제한된 환경에서 신뢰할 수 있는 보조 도구로 활용될 가능성을 보여주었다. 반면, 원위 관절인 발목과 발가락에서는 낮은 신뢰도와 상관성이 나타났으며, 특히 내외측 움직임에서 일치도가 매우 낮아 단일 카메라 기반 시스템의 깊이 추정 한계가 확인되었다. 이로써 정확한 분석이 요구되는 생체역학적인 측면에서의 3차원 분석은 어렵다는 것을 알 수 있으며, 실시간 기능 및 간단한 설치, 낮은 비용을 감안하면 시상면 상의 움직임 또는 단순 동작 분류와 같은 현장 응용 분야에는 유용하게 활용될 가능성을 보인다.

향후 연구에서는 다양한 보행 조건과 인구 집단에서 단일 카메라의 가능성을 검증하고, 원위 관절과 깊이 데이터의 추적 정확도를 높이기 위한 알고리즘 개선 및 추가적인 연구가 필요하다.

References

1. Arrowsmith, C., Burns, D., Mak, T., Hardisty, M. & Whyne, C. (2022). Physiotherapy exercise classification with single-camera pose detection and machine learning. Sensors, 23(1), 363.

Google Scholar

2. Auer, S., Süß, F. & Dendorfer, S. (2024). Using markerless motion capture and musculoskeletal models: An evalu- ation of joint kinematics. Technology and Health Care, 32(5), 3433-3442.

Google Scholar

3. Carse, B., Meadows, B., Bowers, R. & Rowe, P. (2013). Afford- able clinical gait analysis: An assessment of the marker tracking accuracy of a new low-cost optical 3D motion analysis system. Physiotherapy, 99(4), 347-351.

Google Scholar

4. Colyer, S. L., Evans, M., Cosker, D. P. & Salo, A. I. (2018). A review of the evolution of vision-based motion analysis and the integration of advanced computer vision methods towards developing a markerless system. Sports Medicine-Open, 4, 1-15.

Google Scholar

5. Hollman, J. H., McDade, E. M. & Petersen, R. C. (2011). Nor- mative spatiotemporal gait parameters in older adults. Gait & Posture, 34(1), 111-118.

Google Scholar

6. Hulleck, A. A., Alshehhi, A., El Rich, M., Khan, R., Katmah, R., Mohseni, M., Arjmand, N. & Khalaf, K. (2024). BlazePose-Seq2Seq: Leveraging regular RGB cameras for robust gait assessment. IEEE Transactions on Neural Systems and Rehabilitation Engineering.

Google Scholar

7. Hulleck, A. A., Menoth Mohan, D., Abdallah, N., El Rich, M. & Khalaf, K. (2022). Present and future of gait assessment in clinical practice: Towards the application of novel trends and technologies. Frontiers in Medical Technology, 4, 901331.

Google Scholar

8. Kidziński, Ł, Yang, B., Hicks, J. L., Rajagopal, A., Delp, S. L. & Schwartz, M. H. (2020). Deep neural networks enable quantitative movement analysis using single-camera videos. Nature Communications, 11(1), 4054.

9. Maynard, V., Bakheit, A., Oldham, J. & Freeman, J. (2003). Intra-rater and inter-rater reliability of gait measurements with CODA mpx30 motion analysis system. Gait & Posture, 17(1), 59-67.

Google Scholar

10. McGinley, J. L., Baker, R., Wolfe, R. & Morris, M. E. (2009). The reliability of three-dimensional kinematic gait measure- ments: A systematic review. Gait & Posture, 29(3), 360-369.

Google Scholar

11. Moran, M. F., Rogler, I. C. & Wager, J. C. (2023). Inter-session repeatability of marker-less motion capture of treadmill running gait. Applied Sciences, 13(3), 1702.

Google Scholar

12. Moro, M., Marchesi, G., Hesse, F., Odone, F. & Casadio, M. (2022). Markerless vs. marker-based gait analysis: A proof of concept study. Sensors, 22(5), 2011.

Google Scholar

13. Ohri, A., Agrawal, S. & Chaudhary, G. S. (2021). On-device real- time pose estimation & correction. International Journal of Advances in Engineering and Management (IJAEM), 3(7), 1691-1696.

Google Scholar

14. Pirker, W. & Katzenschlager, R. (2017). Gait disorders in adults and the elderly: A clinical guide. Wiener Klinische Wochenschrift, 129(3), 81-95.

Google Scholar

15. Ripic, Z., Nienhuis, M., Signorile, J. F., Best, T. M., Jacobs, K. A. & Eltoukhy, M. (2023). A comparison of three-dimensional kinematics between markerless and marker-based motion capture in overground gait. Journal of Biomechanics, 159, 111793.

Google Scholar

16. Stenum, J., Cherry-Allen, K. M., Pyles, C. O., Reetzke, R. D., Vignos, M. F. & Roemmich, R. T. (2021). Applications of pose estimation in human health and performance across the lifespan. Sensors, 21(21), 7315.

Google Scholar

17. Uhlrich, S. D., Falisse, A., Kidziński, Ł, Muccini, J., Ko, M., Chaudhari, A. S., Hicks, J. L. & Delp, S. L. (2023). OpenCap: Human movement dynamics from smartphone videos. PLoS Computational Biology, 19(10), e1011462.

18. Van Hooren, B., Pecasse, N., Meijer, K. & Essers, J. M. N. (2023). The accuracy of markerless motion capture combined with computer vision techniques for measuring running kinematics. Scandinavian Journal of Medicine & Science in Sports, 33(6), 966-978.

Google Scholar

19. Wang, H., Su, B., Lu, L., Jung, S., Qing, L., Xie, Z. & Xu, X. (2024). Markerless gait analysis through a single camera and computer vision. Journal of Biomechanics, 165, 112027.

Google Scholar

20. Winter, D. A. (1991). Biomechanics and motor control of human gait: Normal, elderly and pathological.

Google Scholar

21. Yang, J. & Park, K. (2024). Improving gait analysis techniques with markerless pose estimation based on smartphone location. Bioengineering, 11(2), 141.

Google Scholar

22. Young, F., Mason, R., Morris, R., Stuart, S. & Godfrey, A. (2023). Internet-of-things-enabled markerless running gait assess- ment from a single smartphone camera. Sensors, 23(2), 696.

Google Scholar

23. Young, F., Wall, C., Graham, L., Stuart, S., Morris, R. & Godfrey, A. (2023). Lightweight markerless identification of temporal gait outcomes with BlazePose. Paper presented at the 2023 IEEE 19th International Conference on Body Sensor Networks (BSN), 1-4.

Google Scholar

24. Yoo, T. G., Choi, J. R. & Kim, D. W. (2012). Dynamics-based walking motion tracking using a single camera. January 2012 Journal of Electronic Engineering Volume 49 SC No. 1.

25. Zhang, Y., Gan, J., Zhao, Z., Chen, J., Chen, X., Diao, Y. & Tu, S. (2023). A real-time fall detection model based on BlazePose and improved ST-GCN. Journal of Real-Time Image Processing, 20(6), 121.

Google Scholar